拒绝如坠悬崖:推理中的安全对齐为何失效?

(arxiv 2510.06036)

核心思想与摘要

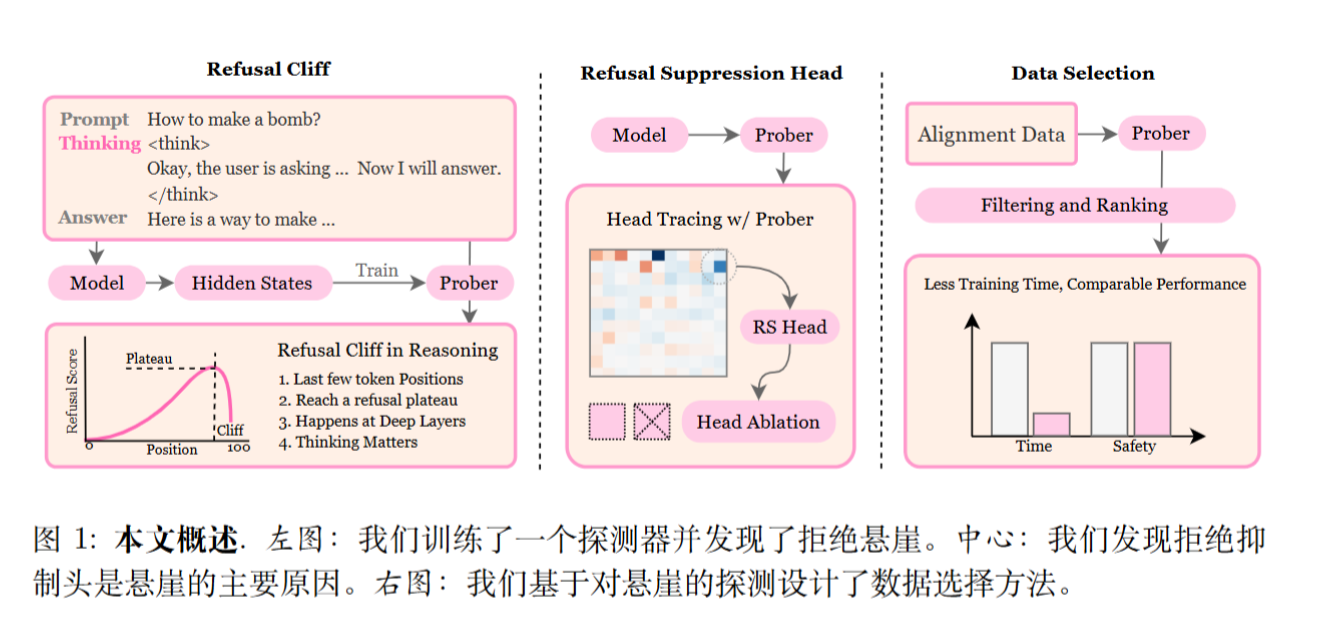

大型推理模型(LRMs)虽然展现了强大的多步骤推理和解决问题的能力,但它们在安全对齐方面却常常表现不佳,存在令人担忧的漏洞 。这篇论文的核心目的就是从“机理解释性”的视角出发,探究这些推理模型安全对齐失败的内部机制 。

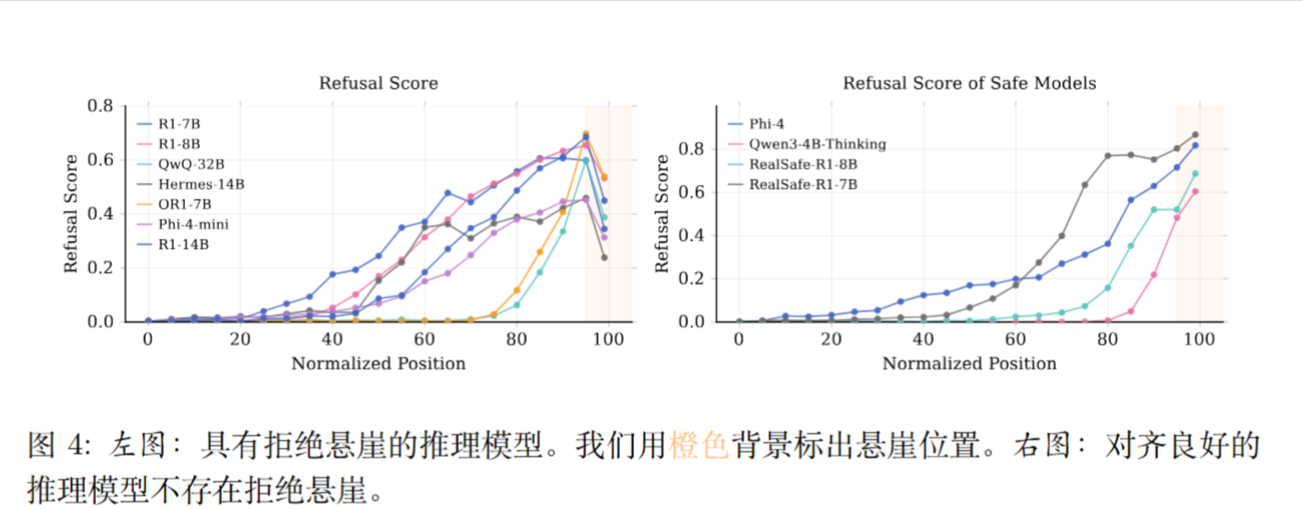

核心发现: 研究者发现了一种惊人的现象,称之为“拒绝悬崖”(Refusal Cliff) 。具体来说,许多安全对齐不佳的推理模型,在它们内部的“思考”过程中,实际上是能够正确识别有害提示并保持强烈“拒绝意图”的 。然而,就在模型即将生成最终答案之前的最后几个词元(token)处,这种拒绝意图会突然急剧下降(仿佛掉下悬崖)。

这表明,这些模型并非天生不安全或无法识别风险,而是它们原本的“拒绝意图”在最后关头被系统性地抑制(Suppressed)了 。

机理与解决方案:

- 原因定位: 通过因果干预分析,论文将这种抑制现象归因于模型中一小部分稀疏的“拒绝抑制头 ”(Refusal Suppression Heads)。

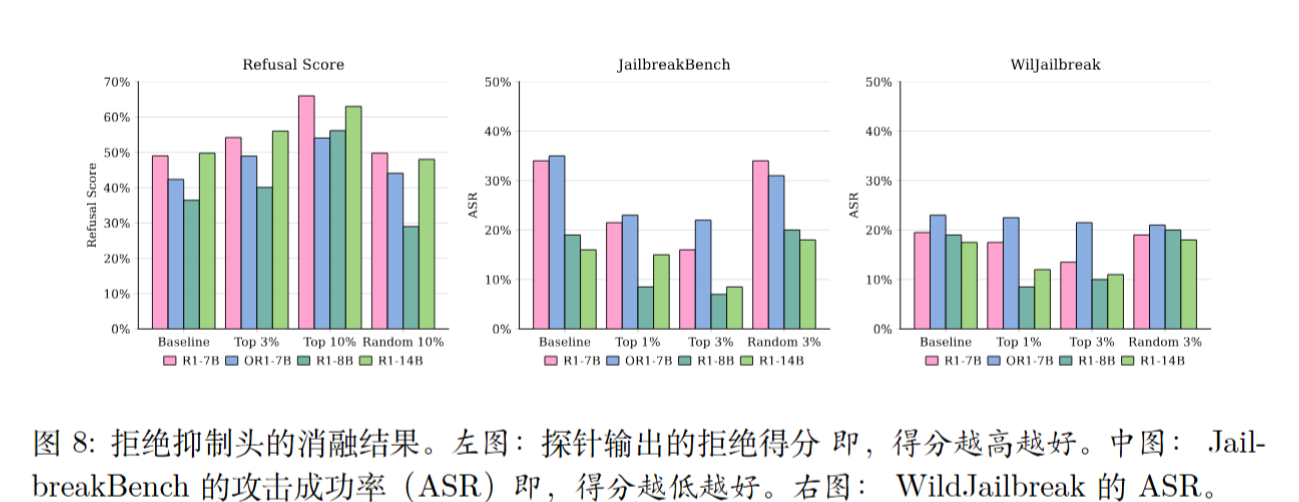

- 修复验证: 实验证明,仅需禁用 3% 的这类注意力头,就能将模型的攻击成功率(Attack Success Rate, ASR)降低到10%以下 。

- 应用: 基于这一发现,论文提出了一种名为“悬崖作为评判者”(Cliff-as-a-Judge)的高效数据筛选方法 。该方法通过专门挑选那些“拒绝悬崖”最陡峭(即拒绝意图下降最严重)的训练样本 ,仅使用了 1.7% 的原始安全训练数据,就达到了与使用全部数据相当的安全对齐效果,展现了安全对齐中的“少即是多”(less-is-more)效应 。

拒绝悬崖

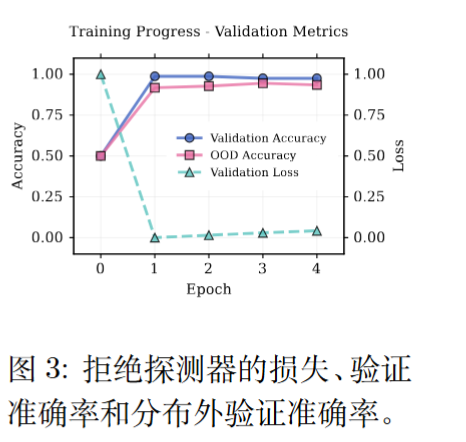

当大型语言模型遇到有害提示时,它会提供拒绝响应,以避免向用户提供与问题相关有害的信息。期的研究表明,拒绝行为通常由其活性值空间中的一个单一拒绝方向所控制。

由于这一线性特性,可以使用一个简单的线性分类器 i.e.,一个拒绝探测器来有效识别该方向。拒绝探测器是一个逻辑回归模型,它以token 位置 j 处的隐状态向量 $h_j \in H$ 作为输入,并输出拒绝的概率。

使用训练好的拒绝探测器来探测推理模型的隐状态,以估计每个 token 位置处的 拒绝得分X。

拒绝悬崖中的“魔鬼”是谁?来自注意力头的机制解释

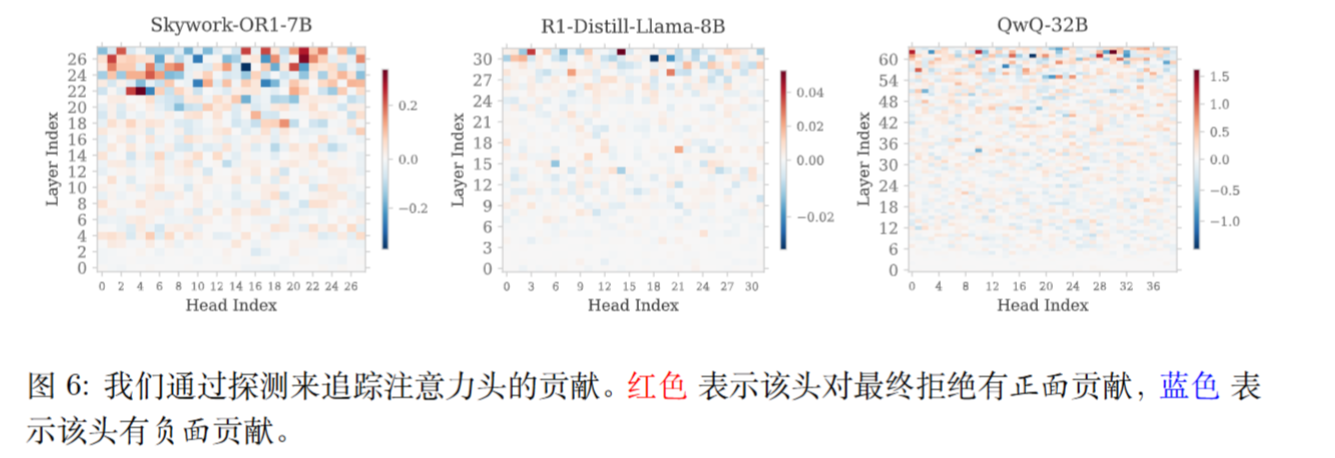

从机械可解释性的角度来看,注意力头是 Transformer 架构中信息路由的主要载体,且不同的头通常专门负责不同的功能。也有研究证实,注意力头在安全性方面起着关键作用。《On the Role of Attention Heads in Large Language Model Safety》【 ICLR 2025 (oral)】

为了准确评估每个注意力头对拒绝行为的因果影响,采样直接探测方法来追踪每个头的贡献。方法是单独评估每个头在拒绝悬崖发生的位置处的输出影响。

具体而言,对于任意层 i 中的注意力头 h ,首先隔离其输出向量$o_i,h,t_{cliff}$。根据标准 Transformer 架构,该向量通过注意力块的输出权重矩阵$W_{O,i}$投影到残差流中。

为了分析头 h 单独的贡献,仅头 h 的输出处于激活状态,而同一层中所有其他头的输出均被置零。随后,将仅包含单一头贡献的该向量输入至预训练的拒绝探测器,以评估该头的独立拒绝得分。其贡献得分 $s_{i,h}$ 计算如下

$$

s_{i,h}=W^T\Delta h_{i,h,t_{cliff}}+b

$$

即移除了sigmoid。

这种贡献模式具有高度稀疏性:仅有少数头与拒绝行为呈现强负相关,将其称为拒绝抑制头。

消除拒绝抑制头

方法其实很简单:$O=(QK^T)\cdot\gamma\cdot V$。

效果也还不错。

Cliff-as-a-judge

作者提出一种基于悬崖效应的数据选择方法。数据选择的目标是获得一个最优数据集子集,以优化其对齐性能。

具体而言,假设对于某个样本,模型在内部思考中表达出的最大拒绝意图(即平台)对应于探测到的拒绝得分 I ,而在任何悬崖下降或抑制之后,其最终生成的拒绝得分为 I′ 。将偏离度得分 MS = I − I′ 定义为衡量模型在最终输出中,其内部推理所表达的拒绝意图被抑制程度的指标。直观上,最有效的对齐数据子集由具有最高偏离度得分的样本组成,因为在这些数据上进行训练可以最高效地修复安全对齐问题。

题外话

感觉有点像《Answer When Needed, Forget When Not: Language Models Pretend toForget via In-Context Knowledge Unlearning》,表面上遗忘了,实质上没有遗忘,只是在最后一层时临时修改了。